Le blues de l’IA

25 juillet 2025/ semsimo / Intelligence Artificielle, KnowledgeGraph, Transformation numérique / 0 comments

Le bluff qui conduit au blues

En juillet, on m’a beaucoup évoqué le côté bluffant des IAs génératives (LLMs). La terminologie me semble en effet adéquate : du bluff. L’intelligence artificielle générative est un artifice de simulation de pensées. Si vous avez le douteux privilège d’avoir à lire des textes quasiment entièrement générés par IA, il est possible que vous ayez fini par constater l’appauvrissement du fond pour l’irréprochabilité syntaxique du style.

Du moins, si le fond est censé relayer un raisonnement personnel, faire preuve de créativité et d’un esprit logiquement critique. Les LLMs sont très bons pour redire ce qu’ils ont déjà engrangé. Pour le reste, sans description des règles et axiomes qui structurent le raisonnement, leurs inductions sont fondées sur la vraisemblance empirique pour les données manquantes ou les prédictions. Cela donne parfois d’étranges approximations, ou des « hallucinations ».

Et au-delà du bluff, les conséquences des engouements et usages actuels me donnent un peu le blues. Cet article met des paroles sur cette musique.

L’emprise de l’empirisme désincarné

La machine n’a pas d’hallucinations, car cela lui supposerait une perception sensorielle du monde réel, ou des idées, ou des sentiments en propre. Ce n’est ici qu’un glissement syntaxique. Un mot proche d’un autre peut générer des confusions dans la réponse, ou l’absence de réponse conduire à trouver les substituts les plus probables par similarité, même si cela ne fait pas sens.

Qu’une machine fasse de l’empirisme ressort aussi d’une mauvaise association. Elle ne peut pas fonder sa connaissance sur l’expérience sensible. Alors peut-on vraiment affirmer qu’elle arrive à la connaissance par l’observation des faits par elle-même ? Tout autant douteuse est l’affirmation d’un probable avènement d’une singularité, une IAG, pour demain. Le rapport RAND prend d’ailleurs cela comme axiome pour développer des scénarios catastrophes, dont on peut critiquer le positionnement.

Scoop, matrix y figure au scénario 7 :The AGI Coup (Centralized AGI Development Disempowers the United States and Its Adversaries). Faire croire en l’IAG n’a rien d’innocent. Ainsi l’emprise de l’idée d’une IA consciente est en elle-même source de mouvements ou de conflits, sans besoin d’avoir une telle IA.

La soif de l'or au prix de l'eau

Le danger des LLMs c’est qu’ils donnent toujours des réponses à des questions, même sans en comprendre le sens. Le risque pour les hommes qui les utilisent, c’est de ne pas voir les limites de l’outil, ou les sous-estimer. Ou, ce qui n’est pas forcément mieux, s’imaginer qu’il est possible de dépasser ces limites, par un nouveau bond en avant qui résoudrait tous les problèmes actuels.

Croire que ce qui génère les problèmes les résoudra est un vieux paradoxe pour réfuter que les avancées technologiques puissent ne pas être des progrès pour l’humanité. Par exemple, non, l’IA ne sera pas la solution pour enrayer le réchauffement climatique. Chaque fois que vous l’utilisez, ça empirera, parce qu’elle fait partie du problème. Une simple conversation avec ChatGPT peut représenter 500ml d’eau (cf. cet article).

Mais qui voudra cesser de lorgner sur la promesse d’une manne économique ? Avec l’IA, c’est encore et toujours « la soif de l’or au prix de l’eau » qui se joue. Il serait judicieux de collecter des données précises à ce sujet, et vite. Surtout quand des bases de faits scientifiques sont en péril aujourd’hui du fait de politiques insensées.

Une éthique un peu pathétique

L’éthique de l’IA est au mieux celles des affaires : une question d‘usage régulé. La clé de cette éthique serait d’être transparent sur les données utilisées, de créer des solutions transparentes, de s’assurer que les employés et les clients sont conscients de la manière dont l’entreprise utilise l’IA et des conséquences potentielles de cette utilisation.

Pour la transparence des données utilisées, on court derrière le bulldozer qui a ravagé la forêt en prétendant la protéger ! La plupart des entreprises qui « créent » leurs propres solutions utilisent des modèles préentraînés (GPT, BERT, …) qui ont déjà été entraînés sur des données éventuellement privées, souvent inefficacement protégées par droit d’auteur, pour les spécialiser. Quant à ceux qui utilisent les APIs d’openAI, sans anonymiser des données personnelles avant de les envoyer, leur conscience des conséquences interroge.

Anthropic , qui a utilisé son IA Claude sur des milliers de livres semble avoir gagné une première manche judiciaire contre les droits d’auteurs, devant un tribunal fin juin. Mais la « victoire » serait peut-être plus ambiguë qu’il n’y paraît (cf cet article de the conversation) : le ver est dans le fruit.

Les solutions « transparentes » me laissent perplexe. Une IA, même entraînée pour fournir des justifications, peut décrire quelque chose qui n’a rien à voir avec la façon dont elle a vraiment procédé. Les « chaînes de pensée » ne sont pas une reproduction d’un raisonnement humain et les chercheurs alertent sur cette interprétation (cf. cet article).

Ne soyez pas trop prompt à déléguer votre raisonnement à l’IA

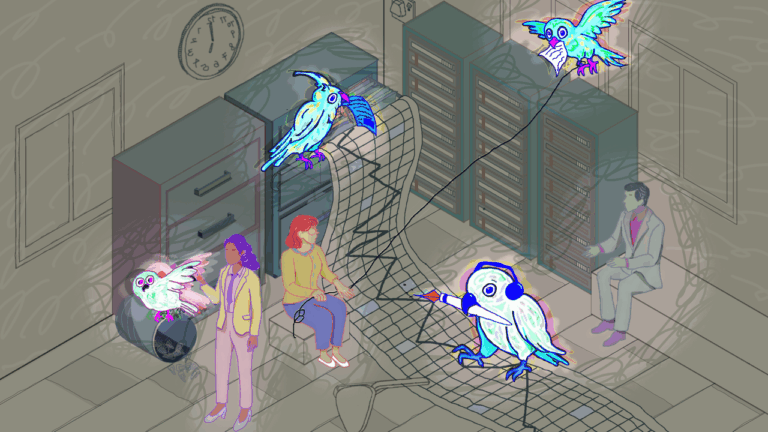

Les IAs génératives actuelles ne « pensent » pas et en les utilisant trop, vous pourriez moins penser.

Selon cet article d’IBM « aujourd’hui, plus d’un tiers des employés (38 %) reconnaissent qu’ils partagent des informations professionnelles sensibles avec des outils d’IA sans l’autorisation de leur employeur. » Le shadow AI a rejoint le Shadow cloud et tous les avatars du Shadow IT.

Utiliser l’IA en cachette, pour l’illusion de plus de capacités, n’est pas sans risque. On peut livrer beaucoup de contenus confidentiels ou d’informations sensibles : du code spécifique avec des données, des conversations slacks internes ou avec des clients, des mails, des CVs de candidats … Un récent rapport de RiverSafe constate qu’un cinquième des DSI an Angleterre font face à des fuites de données sensibles dues à l’usage de l’IA générative par les employés.

Notez bien, cet usage existe déjà au lycée, en licence ou en master. Du point de vue des professeurs, pas forcément pour de meilleurs résultats. Le problème, comme l’indiquent de multiples rapports, c’est que ça devient très vite contre-productif cognitivement. Cet article du 3 juillet de polytechnique insight « IA générative : le risque de l’atrophie cognitive » est une alerte claire sur les risques encourus.

Entraîner votre LLMs domestique à votre service ... pour le meilleur ou pour le pire

Quant à la recherche, le média japonais Nikei Asia a révélé début juillet avoir trouvé dans des preprint publiés sur la plateforme ArXiv, des prompts pour IA afin d’avoir de meilleures évaluations. Les preprint sont des manuscrits qui doivent passer par une revue formelle. Donc les prompts sont inutiles en principe, car les revues doivent être effectuées par relecture humaine.

Est-il plausible d’envisager des thèses écrites par des IAs et revues par des IAs ?. Sans doute aussi peu plausible que des CVs et des lettres de motivation de candidats écrits par des IAs, des postes décrits par des IAs et un processus de sélection totalement automatisé par des agents IAs … On peut toujours penser que le mal est moindre dans le second cas, mais on peut aussi cultiver un doute salutaire. En l’état actuel de la pollution du Web par des IAs , on peut effectivement croire que l’IA est en train de tuer le Web et aussi… une certaine forme saine d’esprit critique.

Je rejoins Ioan Roxin quand il répond à la question « Comment entraîner sa pensée critique face aux réponses de l’IA » (polytechnique insights, 3 juillet 2025). « En appliquant une règle systématique : toujours douter des réponses données par les générateurs de texte et engager sa volonté pour réfléchir attentivement à ce qu’on lit, entend ou croit. »

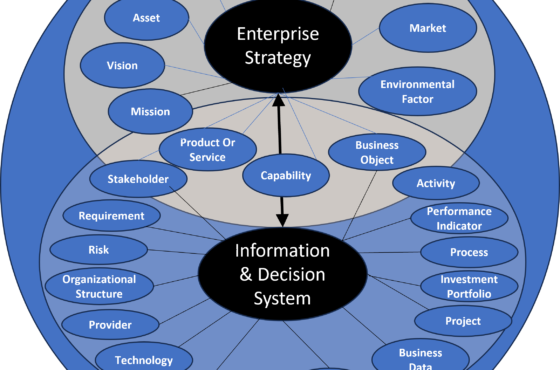

Les LLMs peuvent être de très bons « outils », si on en comprend les limites et les risques. Encore faut-il s’atteler à réduire ces derniers. Des installations en local, de l’IA neurosymbolique avec des knowledge graph et leurs ontologies pour palier les failles du raisonnement inductif par du raisonnement déductif, des outils tels qu’Ollama ou Langchain , nous fournissent des solutions. À condition de faire l’effort d’en analyser le fonctionnement et la pertinence.

Sabine Bohnké