Une technologie d’IA, un idiot utile ? Une affaire d’entendement!

Il y a des expressions courtes qui en disent long sur une époque. Telle celle des dirigeants de Microsoft, cité dans cet article de CNBC , déclarant que la technologie Copilot boostée à GPT-X d’open AI, bien qu’ayant parfois des réponses fausses, fournit du « faux utile » (« usefully wrong »).

On peut se sentir halluciner comme une IA à cette lecture. L’explication est que la génération de texte nous fait « gagner du temps », pour réaliser une présentation, envoyer un mail ou autre chose, et que cela seul est utile, au prix de quelques vérifications ultérieures, bien sûr. Du moins, tant que les gens réalisent que les réponses peuvent contenir des inexactitudes. Cela donne un peu envie de susurrer : c’est comme les « Fake News », non ? Pas de problème tant que les gens s’en rendent compte …

Est-ce gagner quelque chose que perdre du discernement ?

L’idée du « faux utile » vaut la peine d’être débattue. Prenons un peu de temps pour le faire. Cela nous évitera – peut-être – d’en perdre ultérieurement, ou de perdre plus, sous prétexte d’en gagner.

En premier, on peut se demander si un texte ne mériterait pas un raisonnement et une recherche antérieures plutôt que postérieures à sa réalisation. En second, quel genre d’écriture peut représenter un « gain de temps » à être automatisée ? Qu’est-ce que cela indique sur les « écrivains-correcteurs » et les lecteurs de ce type de texte ? En troisième, ne serions-nous pas face à un nouveau glissement sémantique, tel celui qui a remplacé progrès humain par innovation technique ? Ici nous remplacerions progression dans la connaissance et l’entendement par génération automatique de contenu.

Enfin, est-ce que l’usage d’un producteur automatique de textes multimédia et de « faux utiles » vaut-son prix ? On a compris le gain : gagner du temps. Mais l’impact ? Nous pouvons décrypter les intérêts en jeu dans la course au nouveau leadership de l’écosystème économique autour des IA génératives. Nous aurions toutefois aussi quelques intérêts à interroger rapidement l’impact de la mise en place d’un tel écosystème. Surtout si celui-ci suit la « loi de Moore ». Pas celle des microprocesseurs, celle de l’écologie de la compétition.

Est-il toujours utile de gagner du temps en générant du contenu ?

Il y a un intérêt à générer automatiquement des contenus vérifiés pour alléger des tâches répétitives et chronophages. Là où les choses se compliquent, c’est quand cette génération n’est plus utilisée à des fins éthiques. Où quand elle induit des erreurs de raisonnements ou des croyances fausses par la suite.

Nous avons tous vu passer les questions sur l’usage de ChatGPT par les étudiants, qui devrait révolutionner l’enseignement. Une rupture qui conduirait au remplacement des professeurs, ou qui autoriserait une triche sans précédent. C’est oublier un peu vite que la triche est intemporelle, qu’il ne s’agit pas de la première technique utilisée pour tricher, que générer du texte automatiquement n’est ni donner les moyens d’apprendre, ni donner les moyens de raisonner et que l’enseignement n’en est pas à sa première révolution.

L’article de polytechnique insights (chatgpt menace-t-il l’éducation) est très complet sur les enjeux, les problèmes et les pistes de solutions liés aux outils d’IA. Il souligne d ’ailleurs très bien que pour prévenir la triche, le premier enjeu est de faire comprendre aux élèves « pourquoi la culture et les compétences qu’ils acquerront pendant le cours sont importantes, utiles, et intéressantes ».

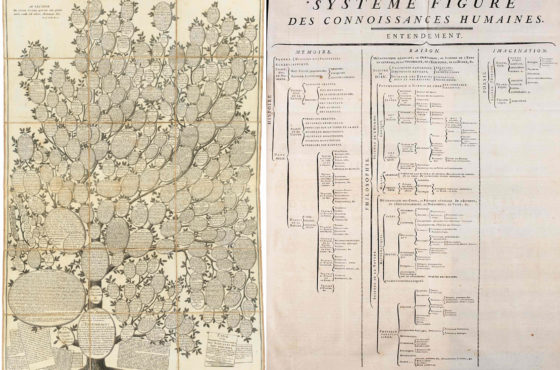

Enseigner, ce n’est pas faire qu’apprendre par cœur et ne faire que travailler la mémoire. En cela ChatGPT a l’avantage de pallier les défauts de mémorisation si on sait le questionner. Mais il ne vous donnera pas la capacité à se souvenir en temps utile, quand il s’agira, pour vous, d’agir. Pour le reste, revenons à Montaigne qui se plaignait de l’enseignement de son temps. «Nous ne travaillons qu’à remplir la mémoire, et laissons l’entendement et la conscience vides». L’entendement et la conscience, ce sont justement les choses qui manquent le plus à une IA générative. Ses utilisateurs, eux, peuvent choisir d’en avoir.

ChatGPT révolutionne quels métiers, au juste ?

Teresa Berndtsson / Better Images of AI / Letter Word Text Taxonomy / Licenced by CC-BY 4.0

Un flot d’articles véhicule que ChatGPT va révolutionner, si ce n’est remplacer, une liste impressionnante de métiers. D’ailleurs, combien de ces articles ont été produits à l’aide de GPT-X ou assimilés ? On peut automatiser le contenu de sites entiers d’actualités quand la performance éditoriale est avant tout évaluée au rythme de production de l’information, pas à la qualité. On peut questionner la perte d’esprit critique due au « gain de temps » d’écriture et de lecture. Les répétitions des mêmes choses peuvent aussi induire une sorte de prophétie auto réalisatrice.

Mais s’il y a des erreurs, on corrigera après.

Pour l’IA générative, il y a un lectorat de masse à cibler qui sera peu embêté par des clichés simplistes. Sans surprise, cela est bien envisagé, si ce n’est déjà fait, à grande échelle. Un article du monde du 22 février 2022 « l’intelligence artificielle infiltre le monde de l’édition » mentionnait des universitaires canadien qui voyaient bien comment cette technologie « pourrait rapidement servir à écrire les prochains roman Harlequin. Là où la récurrence des modèle narratifs est de mise ».

On peut aussi automatiser les annonces pour proposer des emplois et les lettres de refus ou de candidatures. Si l’idée est d’avoir des profils stéréotypés -pardon, qui s’insèrent harmonieusement dans une culture avec des valeurs fortes ; c’est effectivement utile. Le risque n’est que de perdre quelques profils atypiques et de la diversité. On corrigera après.

Il peut aussi être utile d’appliquer les textes de loi à la lettre sans perdre de temps à analyser les contextes uniques. Quand on a des tribunaux débordés, on peut imaginer automatiser les condamnations sur la base de statistiques en s’autorisant une légère marge d’erreur de « faux utiles » pour pouvoir avancer. On corrigera après.

Mais qui est « on » ?

On ne peut pas déléguer notre entendement à une IA

Alina Constantin / Better Images of AI / Handmade A.I / Licenced by CC-BY 4.0

N’attendez pas d’une IA qu’elle réfléchisse consciemment aux conséquences de vos actes. Une IA n’a pas d’entendement humain. On l’oublie vite, parce qu’on oublie par commodité simplificatrice, ce qu’entendement veut dire. Toutes les définitions essaient de saisir cette capacité de compréhension humaine. Je garderai en particulier celle-ci , extraite du CNTRL : » Faculté/action de comprendre, de saisir intellectuellement ou par le cœur la nature, la portée, la signification d’un être ou d’une chose ».

Ne demandez pas à une IA d’être responsable pour vous en tant qu’être humain, cela n’a aucun sens. Certains choisissent d’utiliser une IA pour générer des textes de recommandations « human-like », pour inciter à plus de consommation. Vous pouvez être enthousiastes face à cela, comme face au succès du modèle économique de Shein. C’est votre choix, mais en termes éthiques, on ne progresse pas. En termes techniques, la marque sait bien utiliser l’IA.

Est-ce toujours utile de générer plus rapidement des présentations Microsoft PowerPoint ? ça dépend si vous pouvez, ou non, tout résumer de votre sujet en quelques slides. Il est utile de rappeler le rapport d’Edward Tufte, professeur à l’université de Yale, sur le crash de la navette spatiale Columbia en 2003. Il incriminait l’approche cognitive et trompeuse des slides Microsoft PowerPoint des ingénieurs de Boeing. Une erreur d’approximation ou d’interprétation peut tuer. Or une IA générative ne va pas être rationnelle et quantitative, elle va fournir des approximations. Comme une personne qui ne fonctionnerait que dans le système 1 de Daniel Kahneman et encore, pas à 100% de ses facultés.

Donc si vous gagnez du temps à produire, n’oubliez pas d’en prendre pour corriger les « faux utiles ». De préférence, avant qu’ils ne franchissent la barrière et ne se transforment en « fake news », ou pire.

“Plagiarism”, “fake-news”, “Usefully wrong” , « hallucination » ou gain de temps utile : comment faire pencher la balance?

La séparation entre « usefully wrong » et « fake news » ne tient que par la vérification avant publication. L’article de polytechnique insights précédemment cité évoque également le risque d’un plagiat de bonne foi. « Avec les chatbots, les étudiants peuvent facilement tomber dans le plagiat sans même s’en rendre compte ». Pas de panique, la solution est simple, sans nécessité d’un nouvel outil pour chercher les sources. Il suffit de ne pas « mettre la charrue avant les bœufs ».

Avant de rédiger un article, une thèse, une dissertation, avant de chercher des solutions, il est utile de poser le problème qu’on veut traiter. Il est également judicieux de rechercher ce qui a déjà été dit, ou trouvé, sur le sujet. Ce n’est pas nécessaire de réinventer la roue (pour remplacer la charrue). Mais on peut l’améliorer, si on se renseigne sur l’existant. A titre individuel ou à titre d’entreprise, les techniques existent. Le portail de l’IE le rappelle dans cet article titré « sourcing et fiabilité stratégique à l’heure de ChatGPT et des fakes news » : « l’OSINT s’avère être […] une solution d’une redoutable efficacité dans la lutte contre la désinformation » et « l’OSINT et la veille nécessitent de s’inscrire dans une dynamique, facilitant de ce fait la prise de décision du dirigeant. »

La génération de textes n’est qu’un maillon de la chaîne de décision et pas le premier. Avant de pouvoir l’utiliser à bon escient, mieux vaut réfléchir et affiner son questionnement, déjà s’interroger soi et raisonner. Car l’IA générative ne vous indiquera jamais que les réponses les plus partagées aux questions que vous poserez. Ou alors, elle vous produira parfois des « hallucinations » par corrélations, trompeuses pour les décisions.

L’Intelligence Artificielle et les glissements sémantiques

Chez les humains, le « trouble de la perception qui fait relier des événements ou des phénomènes n’ayant aucun lien entre eux » s’appelle, en psychiatrie, de l’apophénie. Par un drôle de glissement sémantique, on parlera « d’hallucinations » pour une IA, la rendant ainsi presque plus humaine. Car pour avoir des hallucinations, il faudrait pouvoir entendre, sentir, goûter, toucher des choses réelles. Ce n’est clairement pas le cas pour un algorithme.

D’autres glissements sémantiques s’opèrent. Comme celui de croire que la fluidité d’expression dans un langage signifie comprendre ou dire des choses pertinentes. Ou celui de remplacer la notion de progrès par celle d’innovation. Le philosophe Etienne Klein s’est exprimé à ce sujet de nombreuses fois. La vidéo ci-dessous (3mn38) date de 2016. Finalement l’innovation devient progressivement antinomique avec l’idée de changement et la question se pose de réconcilier innovation technique et progrès de société .

Il n’y a rien d’anodin à présenter les avancées techniques de l’Intelligence Artificielle telles des innovations de rupture. La réalité est plus complexe. Car il ne s’agit pas vraiment d’un progrès révolutionnant ce que nous savons. Pas plus qu’il n’est question d’amender nos façons d’agir, ou de nous permettre de vivre mieux, ou autrement.

Quand on nous promet de « gagner du temps », il s’agit donc de faire comme avant, mais plus rapidement. Peut-être ferons nous les choses avec plus d’efficience. L’ennui avec l’efficience, c’est que cela ne nous garantit pas de faire les bonnes choses. D’autre part, quelle confiance avoir en la promesse d’un outil capable de répondre à toutes nos questions, d’être nos yeux et nos oreilles, quand il est dépourvu d’entendement et de sens et incapable d’aller au-delà de la répétition ? A rebours de créer quelque chose d’unique, il fouille dans ce qui existe.

Progrès réel ou bataille autour d’un nouvel écosystème?

Nous avons donc là la possibilité de faire des variations sur des thèmes existants. Jusqu’à quel point s’agit-il de progrès ?

En outre, quand on regarde les étapes de développement d’OpenAI, cela laisse songeur. Lancement d’un produit gratuit pour que les usages soient trouvés par les usagers, passage au payant, début de verrouillage… En effet, la philosophie « open » a été perdue en cours de route. L’éthique également, probablement. Quelle va être la suite ? L’approche évoque les quatre évolutions d’un écosystème d’entreprises selon l’écologie de la compétition de James Moore*: naissance, expansion, leadership, auto-renouvellement.

Dans la naissance on travaille avec les fournisseurs et les clients pour cerner la nouvelle proposition de valeur à créer autour de l’innovation. Lors de l’expansion, on se dépêche de battre les approches alternatives en essayant de devenir le standard du marché. Pour atteindre le leadership, on veille à s’ouvrir et coopérer tout en verrouillant quelque peu le cœur de l’offre pour avoir un pouvoir de négociation fort avec les autres acteurs de l’écosystème et pour finir la phase d’auto-renouvellement consiste à travailler avec d’autres innovateurs, en s’arrangeant pour maintenir des barrières hautes à l’entrée pour ces derniers, et des coûts élevés de changement pour les clients pour gagner le temps d’incorporer les nouvelles idées dans vos propres produits et services.

Quels que soient l’innovation ou le progrès réels derrière open AI, actuellement, il s’agit de rentabiliser ses coûts de développement. Si tout le monde y voit de l’innovation, pourquoi ne pas utiliser la stratégie de créer un écosystème autour ? Peut-être qu’ainsi, la notion de « faux utile », en intelligence Artificielle, finira par avoir un vrai sens. Je ne suis pas convaincue que celui-ci réconcilie l’innovation technique avec le progrès de société.

Faut-il passivement gagner du temps ou désirer faire?

Les GAFAM sont déjà des super prédateurs des écosystèmes d’entreprises habitués à faire main basse sur les possibilités d’innovations. Prendre tout ce bruit autour de l’IA pour une révolution ne fait que contribuer à appauvrir nos réflexions sur une autre approche de la consommation ou sur ce qui ne devrait pas être des « consommables ».

Est-ce qu’il est si pertinent de vouloir des « gains » de temps quand le temps n’a rien d’un bien que vous possédez à votre guise ? Un usage de l’IA qui conduirait à nous transformer en apprenants, consommateurs ou lecteurs passifs, n’a rien d’un progrès désirable. Pour citer Spinoza « Nous ne nous efforçons à rien, ne voulons, n’appétons ni ne désirons aucune chose, parce que nous la jugeons bonne ; mais, au contraire, nous jugeons qu’une chose est bonne parce que nous nous efforçons vers elle, la voulons, appétons et désirons ».

Les technologies d’IA sont effectivement des outils utiles, qui ont leurs limites. Nous devons les utiliser avec entendement pour un futur collectif, pas excuser d’avance des erreurs d’usage pour un gain questionnable.

*Note 1

En 1993, dans un article de la Harvard Busines Review, James Moore, s’inspirant d’anthropologues et de biologistes, étendait une analogie avec les écosystèmes du vivant à une approche systématique de la stratégie, en inventant la notion d’écosystèmes pour les entreprises. Celles ci, dans ce qu’il considère comme une nouvelle écologie de la compétition, vivent dans des communautés économiques dont les dépendances et les nécessaires inter-relations entre acteurs peuvent être comparées à celles se créant dans un écosystème biologique. Chaque entité de l’écosystème affecte et est affectée par les autres, créant une relation en constante évolution dans laquelle chaque entité doit être flexible et adaptable pour survivre.