L’IA hybride contre le syndrome de Frankenstein

Le syndrome de Frankenstein et le traducteur kleptomane

En 2024, faudra-t-il freiner ou accélérer la course à l’IA générative ? L’injonction à souscrire à ce choix binaire nous impose un clivage artificiel entre le camp des transhumanistes/technosolutionistes/optimistes incurables et celui des technophobes/inadaptés/pessimistes invétérés. Tandis que les discours des entrepreneurs stars de la tech cultivaient en 2023 – tout aussi artificiellement – une schizophrénie de docteur Frankenstein partagé entre l’admiration pour sa créature et la peur du monstre créé.

En réalité, l’IA hybride restera l’enjeu de 2024, pas la comparaison entre les IA génératives et la taille des modèles. Face à la course folle de l’IA générative, le couple LLMs et Knowledge Graph semble bien être le mariage de raison.

Chaque jour un peu plus, le battage autour des capacités des nouvelles IA ressort d’une véritable mise en scène marketing. Ce qui pourrait faire passer les vrais enjeux au second plan. Car il y a déjà des conséquences à l’adoption massive de la production abusive de texte par les IA génératives. En effet, ces dernières sont des traducteurs cleptomanes. Elles restituent des données dont elles se sont nourries en volant souvent la véracité et le sens de l’information tout en accentuant les biais qu’elles trouvent. Elles ne sont ni logiques ni conscientes. De surcroît, elles peuvent présenter avec l’argument d’autorité d’un langage recherché un raisonnement totalement faux. Pour limiter leurs inconvénients et exploiter leurs capacités, il faut les coupler avec une vraie organisation structurée de la connaissance.

la schizophrénie des investisseurs : docteur Frankenstein ou docteur Jekyll et mister Hyde ?

Clarote & AI4Media / Better Images of AI / Power/Profit / Licenced by CC-BY 4.0

Un jour, Sam Altman appliquait la loi de Moore à tout. Il s’émerveillait d’être en mesure de doubler l’intelligence de l’univers (celle-ci se mesurant sans doute au nombre de transistors, ce qui peut laisser songeur, voire sceptique (1) ). Le lendemain, ou le jour d’avant, il supputait que l’IA conduirait sans doute à la fin du monde. Fort heureusement, pas sans avoir eu des performances d’entreprises formidables entretemps.

Selon un article de Fortune en janvier 2023, Altman est vu comme un entrepreneur, pas un scientifique ou un chercheur en Intelligence Artificielle. Ainsi, il est connu pour être particulièrement habile à lever des fonds de capital-risque. Est-il seul à l’origine de l’engouement massif autour de ChatGPT? En tous cas, il a su faire bouger vite OpenAI et occuper l’espace avant les autres. Quitte ensuite à ne pas être toujours très clair entre la réalité et la fiction. Ni entre investissements personnels et direction d’entreprise.

Quant à une autre star de la tech, Elon Musk, il a investi à tour de bras dans toutes les start-ups de l’IA, comme un parieur invétéré au casino, tout en réclamant en mars 2023 un moratoire de six mois pour avoir le temps de gagner. Jusqu’à l’union européenne qui a voulu réguler -un peu mais pas trop – un domaine où les européens pourraient -peut-être – obtenir une partie d’une manne économique providentielle.

La course au profit prévaut sur la course au sens

En fin d’année, la course est toujours ouverte. Il ne s’agit guère de stopper quoi que ce soit pour la plupart des acteurs tant les bénéfices financiers semblent alléchants. La crise de gouvernance à la tête d’openAI ne nous a pas distraits longtemps des annonces sur le champ des IA génératives. De toute façon, elle s’est soldée – Silicon Valley oblige – par la victoire de ceux qui veulent gagner plus d’argent. Les comparatifs continuent de s’enchainer sur GPT, Bard, Claude, LLaMa, Q et tant d’autres. Tandis que « l’ethic washing » se porte toujours bien, merci.

Début décembre 2023 Google a lancé Gemini avec une vidéo controversée. Cela a relancé l’éternel débat sur le potentiel oxymore de « l’éthique du marketing ». Dommage, de réelles avancées ont été masquées sous des tours de bateleurs pour mimer une IA totalement interactive.

De son côté, Grok est arrivé après la pause fantôme d’Elon Musk. C’est un bel exploit. Il serait capable de résumer ce que d’autres disent avec le ton sarcastique adéquat en guise d’intelligence. Malheureusement (ou pas), Grok, même habillé de mots un peu différents, est comme les autres. Il pille les données et se comporte en traducteur cleptomane (2). Rien de surprenant qu’il finisse aussi par emprunter au ChatGPT d’OpenAI, vu tous les contenus générés par ce dernier pour répondre à tout et n’importe quoi.

L’étape où les IA génératives citeront les autres IA génératives pour produire du contenu vide ou inexact qui envahira le monde pour rendre inaudible le contenu vérifié n’est pas pour demain.

En effet, ça se passe aujourd’hui !

Les LLMS sont des traducteurs qui trahissent la vérité sans s’en soucier

Luke Conroy and Anne Fehres & AI4Media / Better Images of AI / Models Built From Fossils / CC-BY 4.0

Donc il ne s’agit déjà plus de freiner ou d’accélérer. Nous devons faire face maintenant aux conséquences de l’incapacité à distinguer la notion du vrai ou du faux dans les sources utilisées pour construire la connaissance, étayer des hypothèses, répondre à des questions.

Les LLMs ont appris à être de très bons traducteurs. Ils traduisent les composantes d’une question en la réponse la plus probablement associée, un texte en résumé, un langage en un autre, y compris le langage naturel en langage informatique. Comme traducteurs, nous pouvons en faire de grandes choses. A condition d’interroger des bases de savoirs vérifiés et d’en traduire la substance. Sinon on risque la génération exponentielle de réponses inexactes, ayant l’apparence du vrai et la nocivité du faux.

Ce n’est pas parce qu’on traduit des mots d’un langage à un autre qu’on en comprend le sens. Ou que ces mots désignent des faits réels ou des choses démontrables. Si les données d’apprentissage d’un LLMs ne sont pas très fiables au départ, pourquoi s’attendre à ce qu’il vous donne des réponses justes ? ChatGPT a été initialement entrainé sur des données ou moins de 5% (dont wikipedia english) avaient suivi un processus de curation et de vérification. L’algorithme ne distingue pas le vrai du faux. Il part sur ce qui est le plus communément admis dans ses sources. Donc, il n’a aucune raison de ne pas dire des choses fausses, si ça semble répondre à la question.

Seule l’éthique du savoir peut combattre la crédulité qui fait le monstre

Les LLMs ne sont pas des créatures chimériques douées de conscience autonome et diseuses de vérité. Dans Frankenstein, c’est la façon dont on regarde la créature qui fait le monstre. Ce qui donne naissance aux monstres, c’est prendre des robots conversationnels pour des oracles fiables. L’agrégat de textes dont ils ont été nourris n’est pas une boule de cristal,, pas même une base de connaissances. Cela contient du vrai, du faux, de la fiction, des contre-vérités, des opinions tranchées sans preuves, en bref, la panoplie de ce que des humains peuvent écrire, sans aucune garantie sur la véracité de quoi que ce soit. Outre le fait qu’il y a très probablement un pillage sans vergogne de contenus sous droits d’auteur.

Si quelqu’un veut croire quelque chose c’est son choix. Mais entre croire quelque chose d’invérifiable et croire quelque chose dont on peut vérifier ou prouver le contraire, il y a une échelle de mauvaise foi. Elle se mesure d’abord en degré de connaissances ensuite en degré d’éthique du savoir. Cette éthique doit nous interdire de dire « c’est faux » quand nous ne comprenons pas, bien qu’il y ait des preuves irréfutables de la véracité d’un fait. Nous ne devrions pas plus dire «c’est vrai » si nous ne pouvons prouver que le contraire est faux. Quand il n’y a aucune preuve de la véracité ou de la non véracité d’un fait, nous pouvons choisir de croire l’un ou l’autre mais seulement jusqu’à preuve du contraire. C’est à dire quand il y a assez de connaissances pour trancher.

Tout texte généré devrait pouvoir logiquement être vérifié quand il prétend à la vérité. Or les IAs génératives manquent de capacités dans la démonstrabilité et la vérification de la véracité de leurs hypothèses. Quand on cherche des réponses à des questions d’expertises, la rapidité et la fluidité de l’interaction sont insuffisantes si les réponses sont des leurres qu’on ne peut expliquer.

L’IA hybride contre le syndrome de Frankenstein

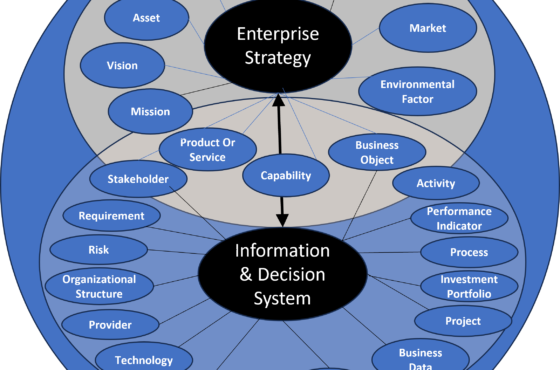

A contrario, l’IA symbolique fonde ses inférences sur des règles logiques et des bases de connaissance de faits établis et connus. Elle est conçue pour que ses conclusions soient explicables. Néanmoins, ce n’est pas sans efforts préalables dans la représentation des connaissances. Elle a également des limites quant à apprendre rapidement et évoluer de façon dynamique. Pourquoi dès lors ne pas coupler les deux? C’est déjà le cas. L’IA hybride qui en résulte a de nombreuses occurrences notamment via le couple LLMs + Knowledge Graphs.

Via l’approche RAG (Retrieval-Augmented Generation), les Knowledge Graph apportent fiabilité avec des faits vérifiés aux LLMs. A l’inverse, ces derniers offrent justement des moyens pour partiellement automatiser les efforts de construction et d’évolution des Knowledge graph.Le couple est fertile sur plusieurs aspects, au-delà de l’explicabilité. L’hybridation est une voie prisée dans laquelle il y a encore beaucoup de choses à explorer et à exploiter.

Reste que l’enjeu de l’IA hybride est double aujourd’hui. D’une part, il s’agit pour tous d’accéder facilement et partout à une connaissance vérifiable et explicable. Ce que ne permet pas l’IA générative. Laquelle au contraire pourrait présenter un risque dans le processus d’acquisition de nouvelles connaissances. D’autre part pour les entreprises, il s’agit de pouvoir faire dialoguer aisément des agents, y compris des systèmes informatiques, avec une réelle interopérabilité sémantique et à moindre frais.

l’IA hybride pour des SI intelligents

Enfin, on peut imaginer une chaîne de bout en bout d’interactions entre l’homme et la machine, afin de concevoir et d’opérer différemment nos systèmes d’information, en les rendant plus intelligents en termes de logique métier.

Mais encore faudrait il que l’on prenne le temps de construire des systèmes performants et sûrs pour leurs usages. Ce qui n’est pas forcément la logique du marché.

Sabine Bohnké.

Notes

1 Quand Sam Altman a posté sur X « SA » nouvelle loi de Moore comme quoi le volume d’intelligence dans l’univers doublait tous les 18 mois, Grady Booch s’est permis de lui expliquer qu’il comparait des choses incomparables. Le post de Sam Altman peut aussi renvoyer à la citation prêtée à Einstein. Il n’existe que deux choses infinies, l’univers et la bêtise humaine… mais pour l’univers, je n’ai pas de certitude absolue.

2 Formule inspirée de la nouvelle de Dezsö Kosztolányi le « traducteur cleptomane »

3 Taloni A, Scorcia V, Giannaccare G. Large Language Model Advanced Data Analysis Abuse to Create a Fake Data Set in Medical Research. JAMA Ophthalmol. 2023 Dec 1;141(12):1174-1175. doi: 10.1001/jamaophthalmol.2023.5162. PMID: 37943569; PMCID: PMC10636646.