l’IA et le temps long du futur

Avec l’IA, nous devons réfléchir à changer de paradigme de croissance, pas répliquer l’existant

Source image, everybodyisone on flickr, licence cc-by-NC-2.0

Les avancées technologiques des outils dits d’intelligence artificielle donnent l’impression d’être au bord d’un changement de paradigme. L’aphorisme est connu : « Il faut que tout change pour que rien ne change ». Passé le retournement de la boule à neige en verre, les faux flocons retombent sur un paysage figé. Car la plupart des usages qui enthousiasment renvoient à des paradigmes existants : la destruction créatrice de Schumpeter, l’Intelligence économique et la guerre de l’information, le paradoxe de l’épée et du bouclier, la croissance vue par le PIB.

Pourtant, nous aurions bien besoin, pour un futur plus durable, d’un peu plus d’innovations dans nos systèmes de pensées. Au vu des dernières tendances, on pourrait croire que les technologies de l’IA ne vont pas nous y aider. Ainsi, ChatGPT donne faussement l’impression d’un bond technologique vers une Intelligence Artificielle robuste, facile d’usage, aux retombées économiques certaines. Néanmoins, sa portée n’effleure pas les défis sociétaux et environnementaux qui nous sont posés. Des défis que propose de résoudre drivendata avec la data science, par exemple. En revanche, les discours sur les effets Whaou des technologies véhiculent toujours les mêmes idées.

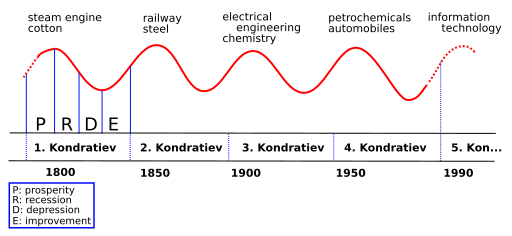

La croissance économique, sans quoi il n’y aurait que régression, serait modelée par des vagues infinies de destructions créatrices et par les innovations de rupture technologique.

Il serait urgent d’arrêter de prendre le TGV en marche pour décider d’un vrai changement de paradigme. Pourquoi ne pas réfléchir au concept de Slow.tech ? Ni low tech, ni tech à tout prix, il faudrait orienter les solutions vers la création de valeur optimum pour toutes les parties prenantes, en répondant réellement aux enjeux de développement durable dans un monde en contraction.

C’est quoi la croissance ? Les vagues à l’âme de la création destructrice

ChatGPT est un arbre qui cache la forêt. Parce qu’on élude la question suivante. Comment les technologies d’IA peuvent contribuer à la redéfinition de la croissance ?

Car quelle croissance voulons nous pour demain ? Posons la question à Jean-Marc Jancovici. « à un moment ou à un autre , ce ne sera plus une croissance au sens économique conventionnel du terme, ce sera une décroissance » […] « Nous n’allons pas devoir réfléchir dans un monde en croissance, mais dans un monde en contraction » [extraits rencontre d’Aix – 03/07/2020.].

Passé l’effet de mode ChatGPT, si on parlait des enjeux de fond liés aux impératifs de changement ? Encore faut-il penser hors du cadre des modèles hérités du passé et revisiter le paradigme de destruction créatrice.

Cette notion a été popularisée en 1942 par Schumpeter dans son livre « capitalisme, socialisme et démocratie ». Il a repris les cycles économiques constatés empiriquement par Kondratieff pour leur donner une interprétation théorique. Schumpeter considère le système capitaliste comme un mouvement de vagues de création destructrice, soutenues par l’innovation et le progrès technique, chacune se substituant à la précédente, pour avancer vers de meilleures conditions de vies. Des innovations de rupture rendent inefficients et dès lors obsolètes des modes de production anciens. Ainsi les entreprises et les métiers traditionnels sont bouleversés, voire disparaissent, car de nouvelles compétences sont exigées.

Les entrepreneurs qui innovent sont les moteurs de ces cycles économiques qui alternent prospérité/récession/dépression/reprise. En théorie, au sein d’un cycle, il y a plus de création que de destruction de valeur. Du moins, une fois l’impulsion initiale intégrée par tous les suiveurs.

Les nouveaux modèles d’affaires issus de l’exploitation de données numériques, tels qu’Uber, AirBnb, Netflix, ont remis Schumpeter au goût du jour. Toutefois, une lecture critique conduit à relever quelques biais dans l’appropriation de la théorie.

Les biais et les mythes de la destruction créatrice

BusinessMan on a horse. Crédit image Shawn Merrit on Flickr , licence cc-by-2.0

L’innovation serait selon Schumpeter le fait d’entrepreneurs visionnaires. Ces chefs de file du futur auraient des capacités hors normes pour percevoir et saisir les opportunités de progrès. C’est un biais d’attribution. Non seulement les innovations technologiques sont de moins en moins le fruit d’un seul individu, mais elles ne sont pas plus le fait d’une seule organisation. Reste un mythe tenace, qu’Anthony Galluzo traite dans son livre « Le Mythe de l’entrepreneur. Défaire l’imaginaire de la Silicon Valley ».

L’autre biais repose sur la conviction que le système peut se réguler grâce à ses acteurs. En dépit de l’amoralité intrinsèque du système capitaliste, la valeur morale de la structure sociale enrichie par le capitalisme garderait à l’ensemble une forme d’éthique.

On peut sincèrement en douter. Le rêve de devenir des licornes rapidement a conduit bon nombre d’entrepreneurs et de start-up à franchir allègrement les barrières de l’éthique des affaires. Si tant est que l’expression ne soit pas un oxymore. La méthode d’analyse de sang de Theranos d’Elizabeth Holmes, la plateforme de cryptomonnaies FTX de Sam Bankman-Fried … Si votre objectif en créant une société c’est l’argent, la notoriété le plus vite possible en surfant sur l’idéologie des ruptures technologiques, pouvez-vous vraiment prétendre construire pour durer et que vous vous souciez réellement des conséquences d’un produit mal fini ou dangereux ?

Enfin, le progrès technique n’est pas forcément synonyme d’élévation du niveau de vie. De moins en moins à terme, si ce progrès suppose de puiser inutilement dans des ressources contraintes, privatiser les biens communs, ou exploiter, ou leurrer, les individus.

Des technologies d’IA progressent en parallèle de leur nocivité

La consommation de ressources non renouvelables nécessaires à la transformation n’entrait pas dans le modèle de Schumpeter. Il n’est pas sûr non plus qu’il ait intégré tous les impacts négatifs des technologies identifiés aujourd’hui ou encore à identifier (pollution, santé, désinformation …).

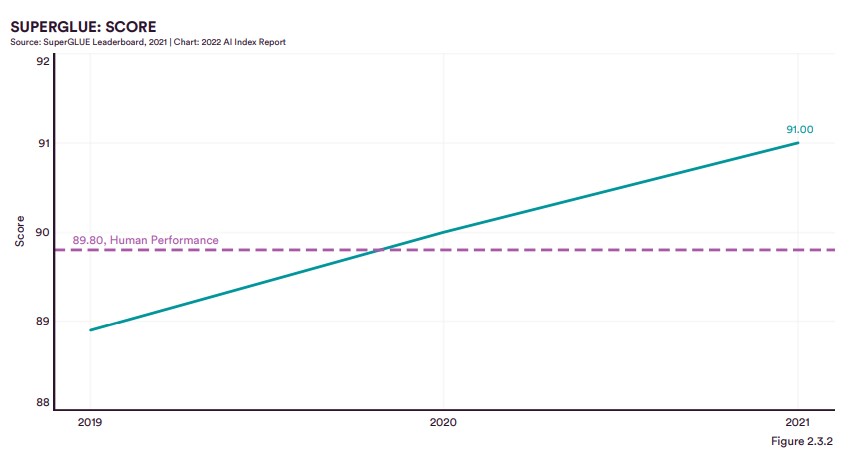

Certes, depuis une décade, les technologies d’IA ont bien progressé. En particulier, au niveau de la lecture et de la compréhension du langage, surtout sur les textes en anglais, les algorithmes ont dépassé les humains.

On peut le tester avec des jeux de données. Les résultats sont dans le rapport 2022 de l’index AI de Stanford. On a encore une différence notable sur la partie raisonnement logique, à condition de dépasser de simples questions avec le test utilisant le jeu de données Reclor.

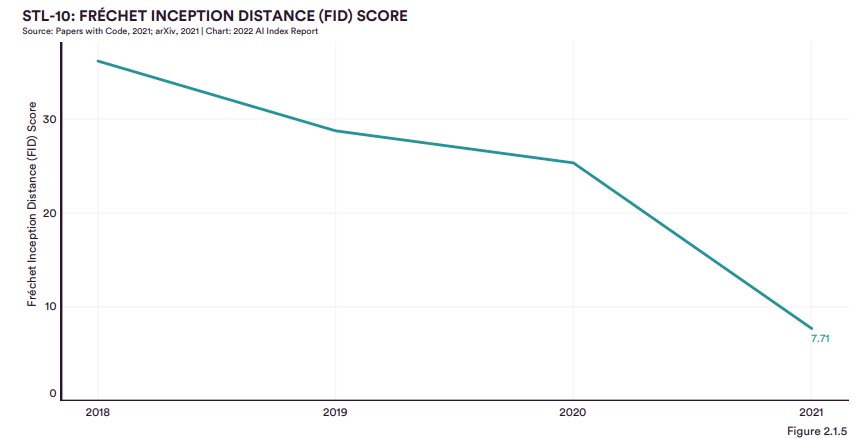

La génération d’images est de plus en plus performante également. On peut renvoyer à l’article de 2020 de Nadia Naffi dans the conversation sur la menace sérieuse pour la sécurité des personnes et de la démocratie du deepfake.

Score SuperGLUE

En utilisant les métriques du benchmark SuperGLUE, la performance du modèle SS-MOE est de 91, celle des humains de 89,8.

En utilisant les métriques du benchmark SuperGLUE, la performance du modèle SS-MOE est de 91, celle des humains de 89,8.

Score SQUAD

En utilisant le dataset de Stanford, SQUAD, on a 95,72 versus 91,21 (humain) sur SQUAD 1.1 et 89,5 versus 93,21 sur SQUAD 2.0. (source AII report 2022)

Score FID sur STL-10

Le score FID mesure la similarité entre une image artificielle et une image réelle. A zéro, on ne fait plus de distinction. (source AII report 2022).

Inquiétante également, la question toujours ouverte des données d’apprentissage. Car si les grands modèles de langages (LLM : GPT3 en est un avec 175 milliards de paramètres) « deviennent beaucoup plus performants au fil du temps », selon l’HAI, ils « sont également davantage capables de refléter les biais de leurs données d’apprentissage » et la dangerosité de leur biais augmente en parallèle. « Un modèle de 280 milliards de paramètres développé en 2021 montre une augmentation de 29% de la toxicité induite comparé à un modèle de 117 millions de paramètres jugé comme l’état de l’art en 2018. »

Les textes Frankenstein : une bombe à retardement pour l’éducation et la science

Tout ce qui brille sous l’angle de l’innovation, n’est pas or, ni synonyme d’un nouveau cycle de prospérité. D’où la question de la création de valeur d’un outil tel que GPT-3 pour générer des textes. Que va-t-on en faire ?

Nous savons qu’il ne s’agit pas de créations, puisqu’il s’agit d’ingurgiter des textes en entrée pour produire un texte Frankenstein en sortie. Un texte dont le corps est nourri d’autres textes découpés et rafistolés pour faire tenir l’ensemble. Dès lors, on peut créer beaucoup de choses qui ressemblent à des plagiats en feignant de ne pas en être.

Exemple, pour les formateurs indépendants, on peut créer de nouveaux cours « Canada Dry ». Ils auront l’air d’être de vrais cours, mais ils auront emprunté à d’autres, et ils ne seront pas forcément cohérents. Dès lors, que vaudrait ce genre de contrefaçon de formation ?

De plus, que penser de l’avenir de tous les textes scientifiques, thèses, articles, etc. ? Sachant qu’avec le dictat « publish or perish », le besoin de reconnaissance des chercheurs fausse le sérieux des publications scientifiques. Si les experts reprennent des données fausses, on va joyeusement vers des résultats faux et le discrédit des méthodes scientifiques. On a déjà affaire, comme l’écrit Philippe Mercure dans la presse canadienne, à une véritable bombe à retardement de la fraude scientifique.

Dans ce contexte, jusqu’à quel point autoriser la collecte de textes par une IA qui ne cite pas ses sources? Publier sur des plateformes ouvertes pour éviter les charybdes des revues prédatrices pourraient vous faire tomber chez les scylla des IA. Vous serez repris, sans crédit et invisibilisé. Donc, il ne sera pas facile de trouver l’investissement adéquat pour l’autonomie de vos recherches.

L’IA est amorale, normal c’est un outil. ça peut aussi être une arme

Un algorithme de machine learning se nourrit de ce qu’on lui donne à apprendre, en bien comme en mal. Un algorithme est amoral. Il peut apprendre à restituer la liste des arguments pour et des arguments contre sur un sujet. Il n’aura pas d’opinions, il cite celles qui prédominent. Se faisant, il accentue les clivages mais il n’a pas la capacité à les résoudre. Chacun piochera ce qui lui convient, selon son degré d’esprit critique et de raisonnement. Comme les réseaux sociaux ont accentué les biais cognitifs (de par les algorithmes de filtrage), si on ajoute un algorithme répliquant des recommandations … Où est l’amélioration ?

Certains prétendent que les algorithmes d’IA sont plus rationnels que les êtres humains. Ils seraient dépourvus de leurs biais émotifs. Donc qu’en déduire d’utile ? Vous voulez un vote par IA ? Imaginons que ce vote soit fait par analyse des sentiments (positifs ou négatifs) trouvés sur le Web. Il suffirait dès lors de produire beaucoup de textes biaisés par une IA en lui enjoignant d’exprimer du positif (ou l’inverse) et on aurait le nombre de textes suffisant pour faire pencher la balance dans un sens ou l’autre.

Ce n’est pas de la fiction. Aurait-on déjà oublié le scandale Cambridge Analytica ?

L’influence est l’art du faire croire, faire savoir et du faire faire. Telle est la définition que l’on va trouver sur le portail de l’intelligence économique. Car l’influence est aussi l’un des trois piliers de l’intelligence économique avec la veille et la protection. On voit bien comment, dans un contexte de guerre économique, les technologies d’IA peuvent devenir des armes.

L’IA , l’intelligence économique et la guerre de l’information

Aux Etats-Unis, les outils de text mining, de catégorisation de l’information ou d’analyse documentaire mis au point dans les universités, sont passés sous le contrôle du ministère de la Défense. Pour mémoire, le Congrès américain a annoncé placer sa priorité sur la défense des intérêts économiques des États-Unis aux débuts des années 90s.

En France, le SISSE (Service de l’information stratégique et de la sécurité économique), rattaché à la DGE, a pour mission d’identifier, protéger et promouvoir les actifs stratégiques pour l’économie nationale. S’il ne fait pas toujours les gros titres des journaux, il a mis en place un dispositif national de sécurité économique qui traite en moyenne 600 alertes par an liées à la sécurité économique. Tandis que le service Viginum a pour mission de détecter et caractériser des ingérences numériques.

Néanmoins, ces dispositifs ne peuvent pas protéger toutes les parties prenantes (entreprises, citoyens, collectivités, associations …) des guerres d’influence.

Certaines technologies d’IA augmentent les menaces d’usage à grandes échelles de moyens déloyaux pour s’emparer de marchés par l’influence ou le piratage. Elles fournissent aussi des outils pour s’en protéger qu’il faut faire évoluer en même temps que les techniques. Ainsi les jeux de données d’entraînement pour les algorithmes de détection de deepfake évoluent en difficulté, de FaceForensics++ à Celeb-DFv2. Mais qui a la capacité à suivre ?

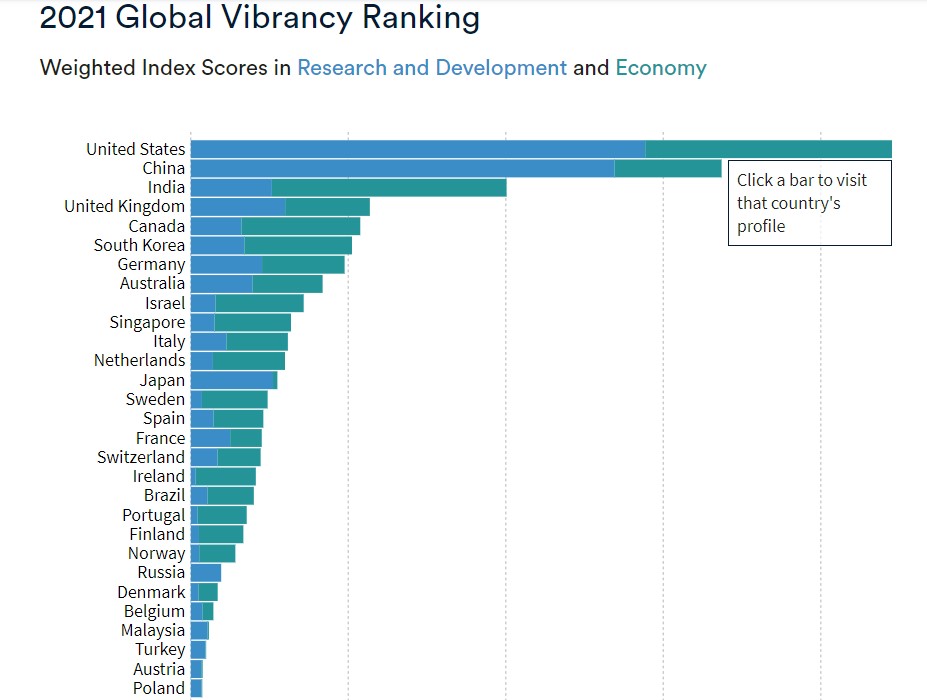

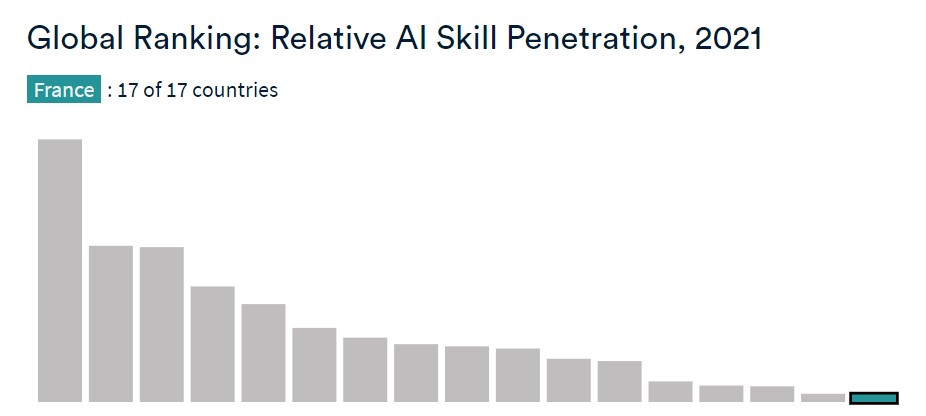

La chine et les Etats-Unis, certainement. La France ? La France est mal placée, en 19ième position sur 22 pays, cf. https://aiindex.stanford.edu/vibrancy/ . Nous avons donc une question cruciale. Comment utiliser l’IA pour entreprendre des changements nécessaires sans bloquer toutes nos compétences sur le paradoxe offensif/défensif de l’épée et du bouclier ?

Position globale relative de la france

Position en ce qui concerne les embauches

Pénétration des compétences liées à l’IA

Le paradoxe de l’épée et du bouclier

Plus on fabrique des épées performantes, plus on renforcera les boucliers. Plus ceux-ci seront renforcés, plus on fera de même avec l’épée, etc. Un paradoxe qui s’applique, dans la guerre économique, à la sécurité et à la visibilité, i.e, l’influence.

Pour les entreprises, pour influencer le plus grand nombre, il faut être visible. Les métiers de référenceur Web, ou plutôt consultant SEO/SEA, ainsi que manager de la communication numérique sont apparus depuis une dizaine d’années. On est passé du besoin d’être visible sur les moteurs de recherche (principalement Google) à la nécessité de décliner une véritable stratégie d’influence sur le Web. Il ne suffit pas d’avoir une (bonne) offre, il faut surtout en faire parler.

Si on peut optimiser le fameux ranking sur les pages résultats du moteur de recherche en produisant des textes automatiquement et sans effort, l’idée est alléchante. Seulement, la génération de contenu par des algorithmes d’IA est banni par Google. Avec de nouveaux algorithmes, il se peut que pendant un certain temps, l’équipe webspam de Google ne détecte pas la nature non humaine des textes. Jusqu’à ce qu’on trouve une parade … et un nouvel algorithme. D’ailleurs, pourquoi ne pas nourrir une IA avec des textes produits par une IA ? Il n’est pas sûr que l’on puisse détecter l’origine. Pas plus qu’il n’est garanti d’avoir un contenu intéressant, in fine.

Pour le piratage, il est à noter qu’un algorithme sera toujours plus patient que vous. Mais surtout plus capable d’enchaîner de nombreuses requêtes sur des failles plus ou moins connues. Là aussi, il va falloir s‘en prémunir avec des nouveaux algorithmes d’IA protecteurs qui pourront détecter les signatures, ou plutôt les comportements, d’IA hackeuses. En attendant, vous pouvez jouer avec ChatGPT pour faire vos débuts criminels en hacker néophyte, ou plus.

Le moteur à deux temps de l’innovation de rupture moderne

Le moteur innovation de Schumpeter semble être devenu un moteur à deux temps, d’un engin ont on ne sait pas pourquoi il avance. Le premier temps c’est communiquer abondamment sur un prototype qui utilise une technologie, sans bien cibler le besoin adressé. Le deuxième temps, c’est utiliser cette technologie pour résoudre les problèmes qu’elle aura créée au premier temps dès lors qu’on lui aura trouvé un usage.

Les investissements privés ont doublé entre 2020 et 2021 sur les start-ups de l’IA (96.5 milliards de dollars versus 46 selon l’AII). Si l’IA fait rêver les investisseurs, leurs rêves ciblent une rentabilité financière à court terme.

Dès lors, pour rentabiliser à court terme l’Intelligence Artificielle, on prend le chemin classique. On continue à penser publicités, visibilités, analyses sociales. On en revient à la captation du temps de cerveau disponible pour booster la consommation. Est-ce là vraiment ce qu’on entend par création de valeur ?

On crie émerveillés à l’innovation de rupture, avant de chercher l’innovation utile. Celle qui a de la valeur pour un ensemble de parties prenantes. Au sens où la valeur est le meilleur équilibre entre la couverture des besoins de ces parties prenantes et la consommation optimale de ressources pour y parvenir.

Repenser l’IA avec la création de valeur, un défi ?

Les prises de conscience des dernières années nous ont conduit à élargir le périmètre de parties prenantes au-delà des seuls actionnaires, et considérer dans les ressources celles de l’environnement. A l’heure de la RSE, de l’ISO 26 000 et de la loi Pacte, chacun aspirerait, selon l’ORSE et le C3D dans leur guide « Loi Pacte et raison d’être : Et si on passait à la pratique: « à l’émergence d’une société nouvelle, plus collaborative, plus redistributive des richesses, plus écologique ».

L’IA peut nous aider à résoudre des problèmes complexes, en ayant une approche Slow.tech sans pression d’investissements privés. Dans la vie humaine, dans la vie des sociétés, dans la vie des entreprises, dans le champ de systèmes d’information, il y a de nombreux défis à relever. Cela demande des efforts, c’est un fait. Cela demande aussi de penser le temps long, dès maintenant, en intégrant la réutilisation de demain dans la création d’aujourd’hui.

Donc pour que l’IA contribue à la croissance de demain, il faut changer le paradigme de la destruction créatrice couplée au technosolutionnisme . On a encore beaucoup de travail, et il y a urgence.